Unser Partner Prof. Dipl. Ing. Mike Christmann und seine wissenschaftlichen Mitarbeiter und FLYING EYE Berater Lucien Lenzen und Benjamin Donderer arbeiten aktuell an einem Forschungsprojekt zur Verbesserung der Bildqualität in Videosequenzen an der Hochschule RheinMain. Es baut auf dem erfolgreichen Forschungs- und Entwicklungsprojekt “EVI“ zur Verbesserung des Kontrasts bei Live-Übertragungen auf. Auf Basis der gewonnenen Erkenntnisse soll eine Softwarelösung entwickelt werden, die im Sicherheits-, Automobil- und Broadcastbereich eingesetzt werden kann.

Unser Partner Prof. Dipl. Ing. Mike Christmann und seine wissenschaftlichen Mitarbeiter und FLYING EYE Berater Lucien Lenzen und Benjamin Donderer arbeiten aktuell an einem Forschungsprojekt zur Verbesserung der Bildqualität in Videosequenzen an der Hochschule RheinMain. Es baut auf dem erfolgreichen Forschungs- und Entwicklungsprojekt “EVI“ zur Verbesserung des Kontrasts bei Live-Übertragungen auf. Auf Basis der gewonnenen Erkenntnisse soll eine Softwarelösung entwickelt werden, die im Sicherheits-, Automobil- und Broadcastbereich eingesetzt werden kann.

In Videoaufzeichnungen, bei denen ein Teil des Bildes von der Sonne angestrahlt wird und ein weiterer Teil im Schatten liegt, ist es meist nicht möglich, Details in beiden Bildbereichen klar erkennbar darzustellen, da die Kameraeinstellung entweder an den hellen oder den dunklen Bildbereich angepasst werden muss. Um Details sowohl in hellen als auch in dunklen Bildbereichen sichtbar zu machen, wird eine Technologie benötigt, die einen großen Kontrastumfang einfangen kann. Diese wird High Dynamic Range (HDR) genannt.

Um HDR bereits bei der Aufnahme zu erzielen, wird in der Fotografie bereits seit längerer Zeit das sogenannte „Tonemapping“ eingesetzt, bei dem der Dynamikumfang der Aufnahme reduziert, also die Differenz zwischen den hellsten und dunkelsten Stellen des Bildes verringert wird.

Mit dem Forschungsprojekt “EVI“ (Enhanced Video Imaging), das 2019 auf der NAB (National Association of Broadcasters) in Las Vegas bereits den „Product of the Year Award“ erhielt, hatten Prof. Mike Christmann und sein Team dieses Verfahren erstmals auf live ausgestrahlte Bewegtbilder übertragen und eine virtuelle Blendeneinstellung entwickelt. “Mit Hilfe eines Algorithmus können so in allen Bereichen Details auch auf handelsüblichen Fernsehern deutlich sichtbar dargestellt werden”, so Prof. Mike Christmann.

Aktuelle Studie im Bereich Automotive

Im aktuellen Forschungsprojekt mit dem Titel “Bildoptimierung von Video-Sequenzen mit hohem Dynamikbereich” testen nun die Forschenden das entwickelte Verfahren während einer Praxiserprobung in realen Anwendungssituationen. Zudem sollen die möglichen Anwendungsbereiche der Methode erweitert und eine Software entwickelt werden, die in Echtzeit arbeitet und über die Eingabe von Parametern flexibel an unterschiedliche Aufgaben angepasst werden kann. In Frage kämen hier beispielsweise der Sicherheits- oder der Automobilbereich, etwa beim elektronischen Rückspiegel oder beim autonomen Fahren. “Auch in diesen Anwendungsfeldern ist es wichtig, dass Details sowohl in den hellen als auch in den dunklen Bildbereichen gut erkennbar sind und dass die Daten in Echtzeit verarbeitet werden”, so Lucien Lenzen.

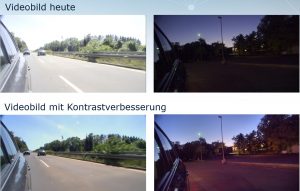

Inzwischen besitzen eine Vielzahl von LKW und auch erste PKW keinen echten Rückspiegel mehr. Dieser wird durch eine Kamera und ein Display ersetzt. Die Bildqualität der Kameras, welche aktuell verbaut werden ist aber eher gering, gerade wenn es um starke Licht- Schattenspiele geht. Mit HDR-Technik in den Kameras und angepasstem Tonemapping wäre es sogar möglich, mehr sehen zu können, als auf einem “echten” Rückspiegel, was nicht nur praktisch, sondern vor allem auch sicherheitsrelevant wäre. Im Forschungsprojekt findet dazu aktuell eine Studie statt, in der ein Auto mit mehreren Kameras ausgerüstet wurde. Die Aufnahmen werden im Anschluss mit dem Algorithmus konvertiert und auf einem Demonstrator (künstliches Cockpit) gezeigt und ausgewertet.

Anwendungsbereich Broadcast

Zusätzlich soll das Verfahren für Fernseh- und Filmproduktionen angepasst werden, um nicht nur während der Übertragung, sondern bereits im Rahmen der Produktion angewendet werden zu können. Viele Produktionen werden bereits mit einem sehr großen Dynamikumfang aufgezeichnet. Dieser kann jedoch meist nicht übertragen beziehungsweise auf den Wiedergabegeräten dargestellt werden, sodass das Bild aufwändig nachbearbeitet werden muss. Mit einer angepassten Version des patentierten Live-Broadcast-Verfahrens könnte eine erste automatische Farbkorrektur durchgeführt und der Vorgang so erheblich vereinfacht werden.

Die Software wurde ursprünglich für die HDR-SDR-Konvertierung im Live-Broadcast entwickelt. Nun wird diese so weiterentwickelt, dass sie auch in einem filebasierten Workflow eingesetzt werden kann. Für neue Produktionen soll sich so der Vorteil bieten, dass nicht zwei separate Gradings durchgeführt werden müssen. Hat der Colorist eine HDR-Version erstellt, kann daraus mithilfe des Algorithmus eine SDR-Version erzeugt werden. Auf der anderen Seite könnte auch Archivmaterial profitieren. Material vom analogen Film hat von Natur aus einen sehr hohen Kontrastumfang. Dieses native Material könnte genutzt werden, um eine hochqualitative Version zu erstellen. Der Fokus der aktuellen Forschung liegt dabei darauf, die Software an die Anforderungen und Arbeitsweisen der zukünftigen Anwender anzupassen. Dazu arbeitet das Team um Mike Christmann mit mehreren deutschen Rundfunkanstalten zusammen.